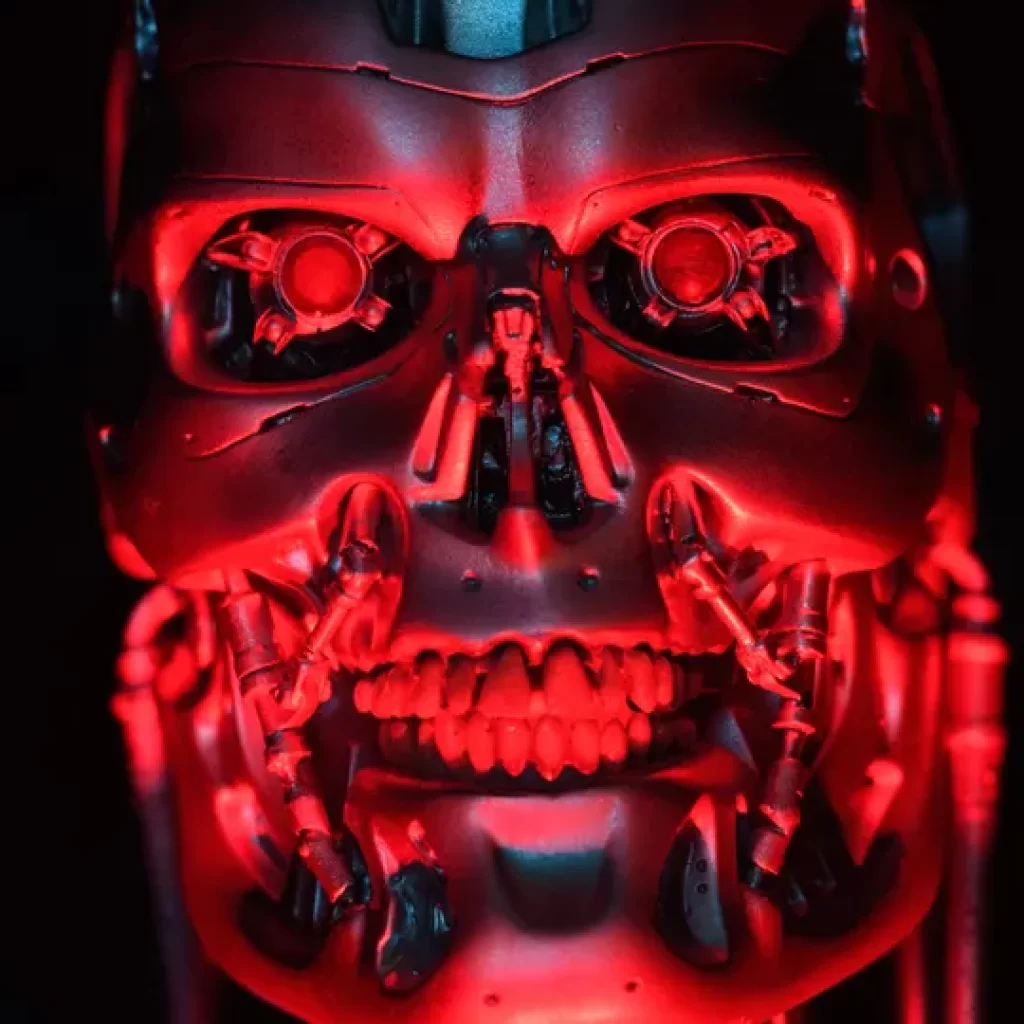

Hace cuarenta años, en julio de 1984, se publicó Neuromante en Estados Unidos, la novela con la que el escritor canadiense William Gibson dio origen al género de ciencia ficción ciberpunk. Tenía todos los temas del futuro: «vaqueros de consola» navegando por el «ciberespacio», guerras entre enormes multinacionales tecnológicas y, después, inteligencia artificial que se volvía autónoma y escapaba para luchar contra los humanos.

Hoy en día, la idea de que los sistemas de inteligencia artificial puedan llegar a ser sensibles es, cuando menos, controvertida, pero que puedan llegar a atacar a los humanos no es imposible. Al contrario, es un posible escenario futuro, sobre todo si no tomamos las contramedidas adecuadas, incluidas las legales. «La inteligencia artificial está creando nuevas oportunidades en el mundo criminal, pero conlleva enormes riesgos», explica a WIRED Stéphane Duguin, ahora director general de CyberPeace Institute pero durante años funcionario de Europol, el servicio policial europeo en el que trabajó para combatir el crimen organizado.

La industria del cibercrimen quiere maximizar beneficios

La inteligencia artificial ya se utiliza mucho, opina Duguin: es una herramienta tecnológica que permite automatizar, y por tanto hacer más eficaces y baratas, muchas actividades que son muy costosas para los atacantes. «La ciberdelincuencia», menciona Duguin durante un encuentro organizado en el Instituto Universitario Europeo de Florencia por Microsoft, «es una industria que, como tal, busca beneficios. Hoy en día se utiliza mucho trabajo manual técnico para todos los aspectos de los ciberataques. Automatizar una parte o incluso la totalidad significa reducir costos y aumentar los beneficios de los ciberdelincuentes».

La IA lo hace posible y, según Duguin, ya se está trabajando en ello en el mundo criminal. Es un sistema muy grande», destaca Clint Watts, director general del Centro de Análisis de Amenazas de Microsoft, «con muchos actores diferentes que se coordinan entre sí». Una cadena que ya ha producido herramientas como WormGpt, la alternativa a ChatGPT disponible en la dark web y, sobre todo, sin los ‘frenos inhibidores’ programados por OpenAI en su chatbot.

Sin embargo, existe otro riesgo, que parece sacado directamente de una novela de ciencia ficción ciberpunk, y no es el de que los ciberdelincuentes pierdan su trabajo. «Con la IA, los ataques», según Duguin, «pueden llegar a ser completamente autónomos y avanzar por su cuenta, sin control ni límites». En la práctica: una vez construido un sistema autónomo capaz de atacar redes, piratear infraestructuras estratégicas, engañar a los sistemas de defensa o incluso desinformar a la opinión pública de un país, basta con escribir una instrucción para que lo haga todo solo. Pero, ¿qué pasa si sigue y sigue?

La cadena de la ciberdelincuencia

Sistemas como éste pueden tener repercusiones en ámbitos muy diferentes. Pueden perturbar la red energética de un país o manipular la información en unas elecciones. Esto último es igualmente preocupante. «En Europa, en comparación con otras zonas del mundo», destaca Jakub Kalenský, director adjunto del Centro Europeo de Excelencia para la Lucha contra la Amenaza Híbrida, «no vemos mucha manipulación de la información. El principal actor es Rusia, que explota metodologías muy antiguas que se remontan a la Guerra Fría». Pero el riesgo de automatización inteligente de los ataques y la posible pérdida de control también es real en este frente.

La tecnología en este ámbito está madurando a gran velocidad y avanza cada vez más rápido. Así lo explicaron durante Next 2024, el evento organizado en Atenas el pasado mes de junio por la empresa rusa de ciberseguridad Kaspersky, dos investigadores del Global Research & Analysis Team, Marco Preuss y Dan Demeter. «El pipeline tecnológico de la ciberdelincuencia se enriquece con competencias y herramientas cada vez más centradas en la inteligencia artificial». Se está produciendo una verdadera «democratización» de las herramientas de inteligencia artificial para la delincuencia, comentan los investigadores de la empresa (que posteriormente recibió una prohibición de venta de sus productos en el mercado estadounidense dictada por el Gobierno de Estados Unidos), sin los «bloqueos» que tienen los grandes modelos comerciales.

¿Tratar la IA como electricidad o como armas nucleares?

Mientras que en el escenario futuro se multiplican los agentes personales de inteligencia artificial en nuestra vida cotidiana, la delincuencia organizada ve la oportunidad de explotar la IA para realizar ataques y manipular los sistemas existentes. También y especialmente los futuros agentes personales. En este doble riesgo-peligro subyace la falta de transparencia y ética de la inteligencias artificiale que estamos construyendo.

La neurocientífica cognitiva y evangelista de la IA Lilian Balatsou explica: «Los modelos de IA no pueden explicar las razones de las decisiones que toman, y los entrenamos con datos que a menudo están llenos de sesgos y son defectuosos». El riesgo de abusos y violaciones de las tecnologías construidas de esta manera es muy alto, según los expertos de Kaspersky. Y la pregunta, como la resume el futurólogo griego Dimitris Dimitriadis, pasa a ser: «¿La inteligencia artificial es como un arma nuclear o como la electricidad? ¿Una revolución para la sociedad o un riesgo existencial?».

Según Stéphane Duguin, la decisión debe ser clara. «Aunque no creamos en la hipótesis de un sistema de IA capaz de realizar ataques completamente autónomos, ¿podemos aceptar el riesgo de no hacer nada? Porque, si funcionara, no podríamos hacer nada». Por eso, de acuerdo con Duguin, deberíamos tratarlo como las armas bioquímicas, es decir, prohibir el desarrollo de sistemas de ataque totalmente automáticos, introduciendo en la estructura misma de nuestras sociedades la idea de que no se debe hacer. Al final», añade Duguin, «la cuestión no estará en la normativa, que con la Ley Europea de Inteligencia Artificial va en la buena dirección , sino en quién la aplica y cómo. Eso marcará la diferencia».

Artículo publicado originalmente en WIRED Italia. Adaptado por Mauricio Serfatty Godoy.

También te puede interesar…

- WIRED Summit 2024: el célebre físico y futurista Michio Kaku en México junto a expertos en ciencia y tecnología.

- Nicolás Maduro y Elon Musk se declaran la guerra en redes tras las elecciones en Venezuela

- 📨 Mantente al tanto de las últimas noticias de WIRED desde Google News, en nuestro Canal de WhatsApp o en el newsletter diario.

- Punta Colorada, el paraíso del surf en Oaxaca que deportistas y científicos defienden incansablemente

- ¿Qué son las máquinas del fin del mundo y por qué el Pentágono quiere gastar tanto en una?

- Tecnología y deporte: sigue la cobertura de WIRED sobre los Juegos Olímpicos 2024.

notiveraz