La Unión Europea plantea una suspensión de cinco años de esta tecnología a fin de analizar su impacto más notable

Tal y como comentábamos en un anterior reportaje, la Comisión Europea pretende regular la Inteligencia artificial (IA) en los próximos años. Se trata de ver su viabilidad dentro de un marco normativo que proteja los derechos de los ciudadanos.

Ahora Scotland Yard, la policía británica, hace pruebas en Londres para su uso de cara a perseguir la delincuencia callejera.

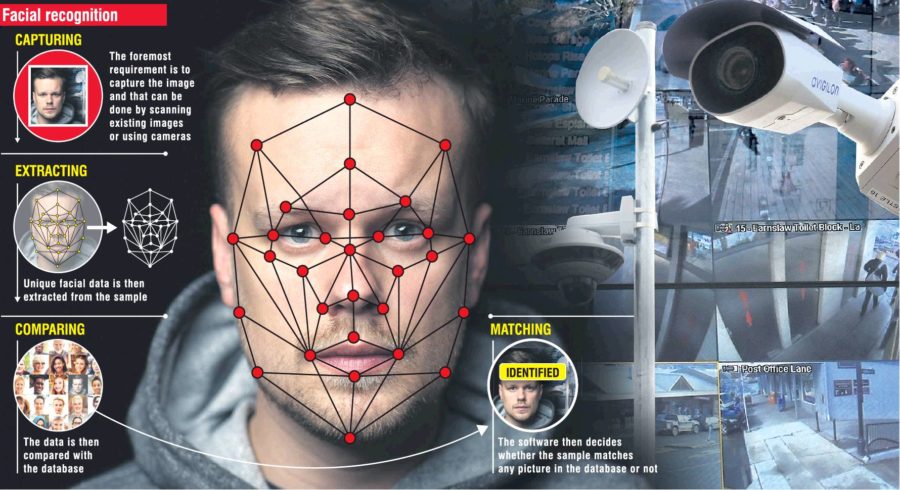

Nuestra publicación ha preguntado a varios expertos en privacidad, sobre esta figura del reconocimiento facial aplicación dirigida por ordenador que identifica automáticamente a una persona en una imagen digital.

Dicha herramienta realiza un análisis de las características faciales del sujeto extraídas de la imagen o de un fotograma clave de una fuente de vídeo, y comparándolas con una base de datos.

El debate acaba de empezar.

PREOCUPA EL USO QUE HACE CHINA: TECNOLOGÍA INVASIVA

Recién aterrizado de Bruselas, José Luis Piñar, único español en el Comité Científico del Computers, Privacy & Data Protection (CPDP), cumbre anual de privacidad donde todos los años abordan cuestiones capitales en este campo, advierte: “No está gustando nada lo que se está haciendo en China con esta tecnología. La están utilizando para vigilar y controlar. Se captan datos, incluso sin ser conscientes de ellos los interesados, y se utilizar para finalidades distintas de las originales planteadas”.

Piñar, responsable en España de la Cátedra Google sobre Privacidad, Sociedad e Innovación de la Universidad CEU San Pablo, cree que es una de las tecnologías más invasivas existentes relacionadas con la inteligencia artificial “permite controlar, vigilar y hacer seguimientos masivos de personas. No solo por motivos de seguridad, sino por cualquier motivo”

En España, no existe regulación sobre reconocimiento facial todavía.

“En principio esta técnica depende del alcance del tratamiento que se haga. Si se trata de captar imágenes para identificar a una persona, estamos ante datos biométricos regulado por el artículo 9 del RGPD y datos especialmente protegidos que requerían consentimiento expreso del interesado”.

En este contexto, “la empresa debería hacer una evaluación de impacto sobre datos masivos especialmente protegidos y, en su caso, si observa las medidas de seguridad se observa que no son las adecuadas habría que hacer una consulta previa a la Agencia Española de Protección de Datos para que dijese si considera adecuada dicha actividad. Y al final, autorizar el tratamiento de datos”, destaca Piñar.

El informe filtrado desde Bruselas sobre la opinión de la Unión Europea sobre la inteligencia artificial y sus deseos de paralizar, de forma momentánea, la tecnología del reconocimiento facial, podría generar que el Comité Europeo de Protección de Datos, antiguo Grupo del artículo 29, hiciera algún dictamen sobre dicha tecnología, a fin de aclarar más la relación de esta tecnología con la privacidad”.

Sobre el Reglamento General de Protección de Datos (RGPD), José Luis Pinar recuerda que “tiene un artículo clave que es el 24 que ayuda a predecir el futuro a corto y medio plazo. Aunque no sabemos cuál será la situación futura ese artículo, nos indica que por encima de todo el principio básico es el de proteger los datos personales y ese escenario no debería cambiar”.

¿CÓMO ENCAJAMOS EL RECONOCIMENTO FACIAL?

Para Ricard Martínez, director de la Cátedra Microsoft de Privacidad y Transformación Digital de la Universitat de València,“el uso de sistemas avanzados de reconocimiento facial con fines policiales plantea retos particularmente complejos”.

Y precisa: “De una parte, la percepción del riesgo por una sociedad altamente vulnerable está generando este tipo de respuestas para la detección temprana de delincuentes altamente peligrosos genera una acogida social y política favorable”.

En su opinión, “la experiencia demuestra que no podemos dejar en manos de una fe ciega en la tecnología ámbitos tan sensibles”.

“En primer lugar, porque los investigadores han acreditado que los riesgos de discriminación asociados al sesgo del algoritmo producen efectos perniciosos cuando se aplican a la seguridad ciudadana, a la prevención del delito, o la evaluación del grado de inserción o educación alcanzado por una persona en prisión”.

Al mismo tiempo, destaca que “este sesgo discrimina por razón de clase social, de origen nacional o de grupo racial. En segundo lugar, como puso de manifiesto la sentencia Digital Rights Ireland deberíamos considerar si una medida de vigilancia masiva supera el juicio de proporcionalidad decantado a lo largo de los años por el Tribunal Europeo de Derechos Humanos, las cortes constitucionales nacionales y el Tribunal de Justicia de la Unión Europea”.

Desde el punto de vista de Martínez, “este tipo de tecnologías suponen vigilancias generales preventivas que nos afectan a todos. En España, por ejemplo, tendrían un difícil encaje a pesar de las posibilidades que ofrece la Ley Orgánica de Videovigilancia. Y a pesar de ello, se suceden cada vez más las noticias de municipios que vigilan con drones y cámara de alta definición todos sus términos municipales con base en normas muy discutibles como son las Ordenanzas”.

“Otro elemento como la predeterminación normativa debería acotar los supuestos a los imprescindibles, definir claramente los procedimientos, y establecer condiciones de trazabilidad y fiscalización del algoritmo y de las personas”, indica Martínez.

Y concluye: “Estamos obligados a abordar estas materias desde el rigor. Sería sencillamente estúpido desproveer a las Fuerzas y Cuerpos de Seguridad de herramientas útiles para la prevención y la investigación del delito”.

LOS INTERNAUTAS, PREOCUPADOS

Ofelia Tejerina, presidenta de la Asociacion de Internautas (AI), es autora de un libro, “Seguridad y Privacidad del Estado”, que es la base de su tesis doctoral, en la que analiza las tecnologías que puede tener cualquier Estado a su alcance para, con la excusa de garantizar la seguridad, controlarlo todo e invadir la privacidad de los ciudadanos.

“El uso del reconocimiento facial para monitorizar ciudadanos de forma masiva implica evidentes peligros”, apunta Tejerina.

“Esta tesis viene avalada por varias sentencias del Tribunal Constitucional, una de las primeras fue del año 2000. Se manejan gran cantidad de datos y en el caso de una brecha de seguridad los ciudadanos pueden verse desprotegidos”, revela.

Al igual que la huella dactilar, el reconocimiento facial, como datos biométricos identifican de forma más fiable al ciudadano.

Sobre la moratoria de cinco años que plantea la UE, para estudiar a fondo la repercusión del reconocimiento facial, “le parece buena idea, siempre y cuando esa moratoria sea prorrogable. Hay que asumir que se debe buscar una regulación específica para este nuevo uso de la inteligencia artificial. Habrá que ver cuál es el calado de esos riesgos que se van a estudiar en esos próximos cinco años”.

Para la presidenta de la AI, “ha pasado con el uso del PNR y va a pasar con el reconocimiento facial. Se busca una excusa relacionada con la seguridad nacional para introducir este tipo de tecnologías altamente complejas. Es el planteamiento que EEUU desde el 11-S y la caída de las Torres Gemelas viene haciendo de santificar la seguridad por la privacidad de los ciudadanos”.

El trabajo de técnicos y juristas parece inevitable.

“Habrá que ver si se logra una técnica de reconocimiento facial exenta de riesgos”, aclara esta experta.

“De momento la Agencia Española de Protección de Datos no se ha pronunciado sobre este tema ni ha sancionado ninguna práctica en este debate que ahora se inicia. Hay que proteger esfera privada del ciudadano”, señala.

Desde la AI se señala su uso desproporcionado si se utiliza para el acceso a alguna entidad privada.

“Ya ha habido recelos con el uso de la huella dactilar para el acceso a determinados lugares. En el caso de que nos enfrentemos a un sistema de reconocimiento facial podemos pedir al propietario del sistema que nos dé un sistema alternativo menos invasivo. Si nos lo deniegan podríamos pedir una consulta en la AEPD para que aclare la situación”, concluye.

UNA REGULACIÓN PRUDENTE

Marcos Judel, presidente de la Asociación Española de Privacidad (APEP) cree que “temas como la inteligencia artificial o el reconocimiento facial requieren que se debata sobre la idoneidad o no de regularlos de una forma más concreta y especial. Para ello, se han de conocer los riesgos para los derechos y libertades de las personas y valorar si establecer límites al uso de estas tecnologías y cuáles poner”.

El presidente de la APEP es de la opinión de que “el uso de esta tecnología a gran escala y sin mínimos controles puede llevar a situaciones que pueden afectar a la libertad de las personas a niveles preocupantes, como conocemos ahora el uso que se hace en China para localizar y seguir a determinados grupos étnicos”.

Judel señala que “las nuevas normativas de esta índole deben incluir en su discusión reflexiva, sin legislar en caliente, a todas las partes implicadas, así como a la sociedad civil, como representante de los sujetos afectados, para establecer un sistema equilibrado que proteja a las personas y permita el desarrollo de otros elementos también importantes, como el progreso de los negocios o la seguridad”.

Y destaca que “los profesionales, que somos parte en lo que se refiere a aplicación de normas, requerimos de normativa que sea clara, entendible y puedan ser aplicada con seguridad jurídica”.

“En el trasfondo de una regulación sobre reconocimiento facial estamos los ciudadanos con nuestro derecho fundamental a la protección de datos”.

Judel es de la opinión de que “los legisladores deben contar con los expertos de la privacidad a la hora de discutir, evaluar y redactar las normas, somos quienes asesoramos a empresas y organismos públicos como delegados de protección de datos o abogados o expertos en seguridad”.

Hay que evitar normas difusas que no aportan nada.

Para el presidente de la APEP, “cuando las normas tienen un equilibrio entre obligaciones y libertades adecuado favorecen su cumplimiento, bien desde una perspectiva voluntaria como la adopción de códigos de conducta o la autorregulación bien, aprovechando el cumplimiento normativo como valor añadido de diferenciación, como sucede con la protección de datos en Europa”.

NotiVeraz